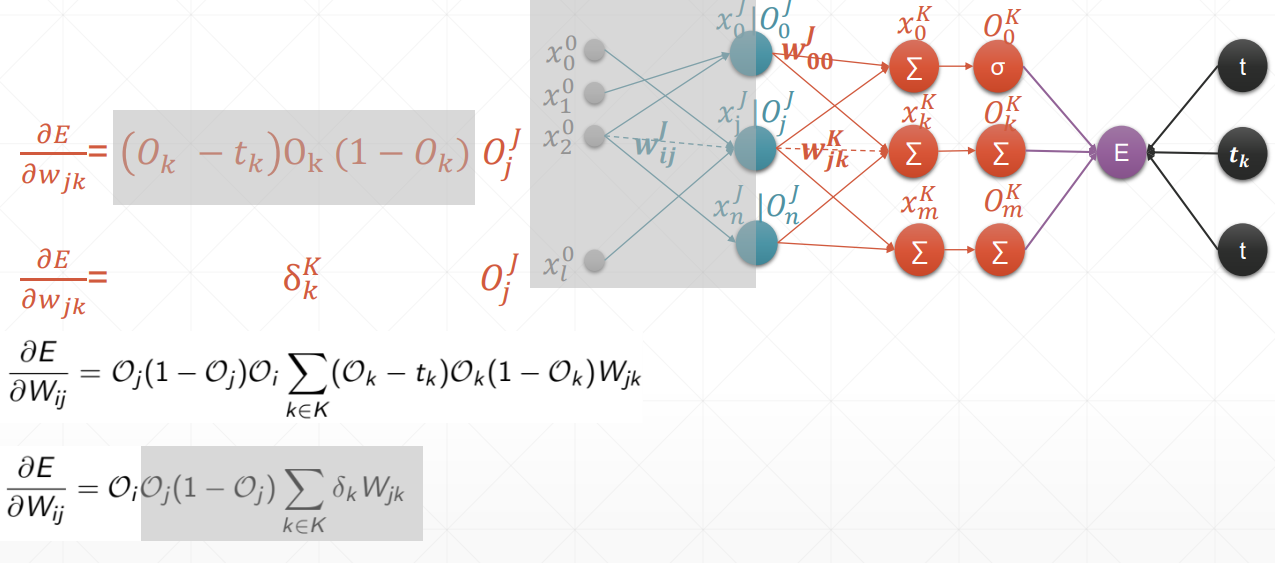

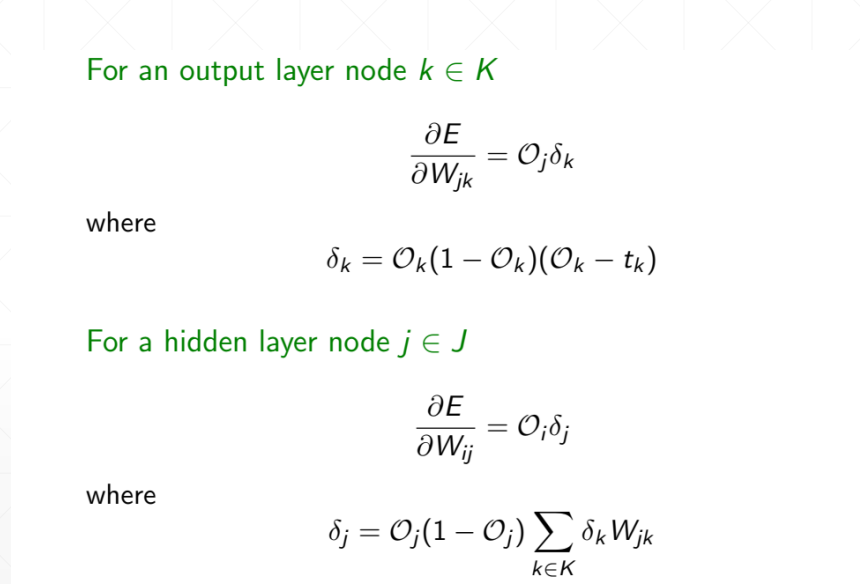

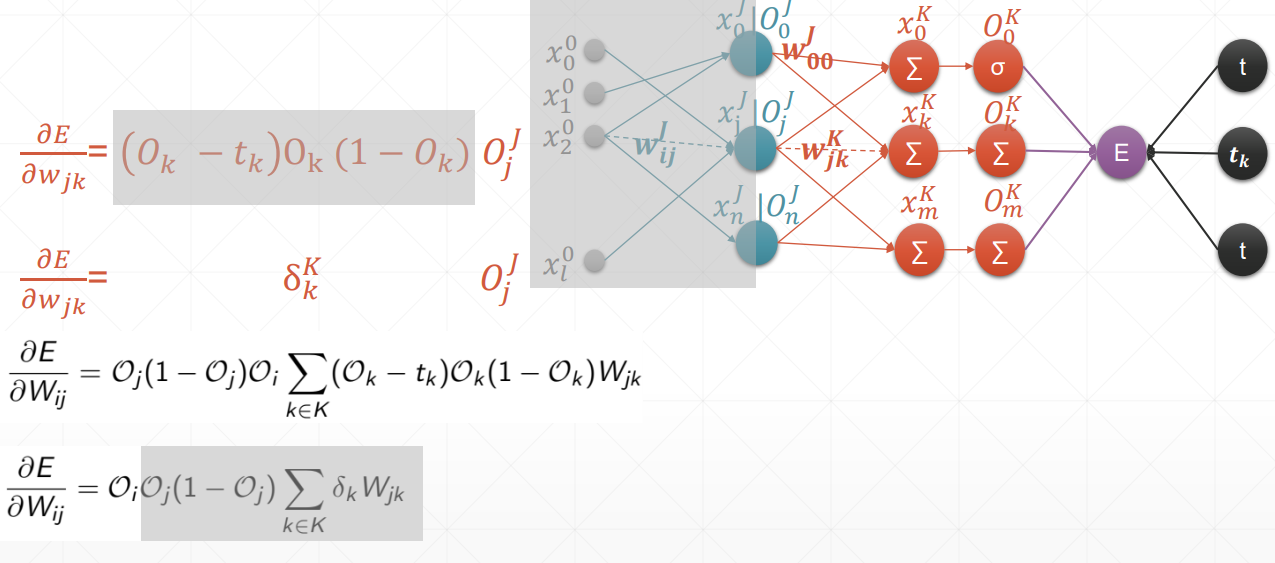

反向传播

这里的激活函数统统是sigmoid

总结:在案例中,oi是输入层,但我们要求得是一个广泛使用的式子,也就是说,在这里我们认为oi是隐藏层。

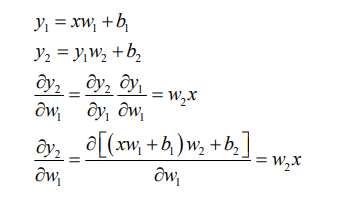

链式法则

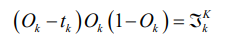

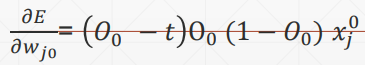

多输出感知机的梯度推导

激活函数仍然是sigmoid,且y的估计函数用到的仍然是一次线性回归函数

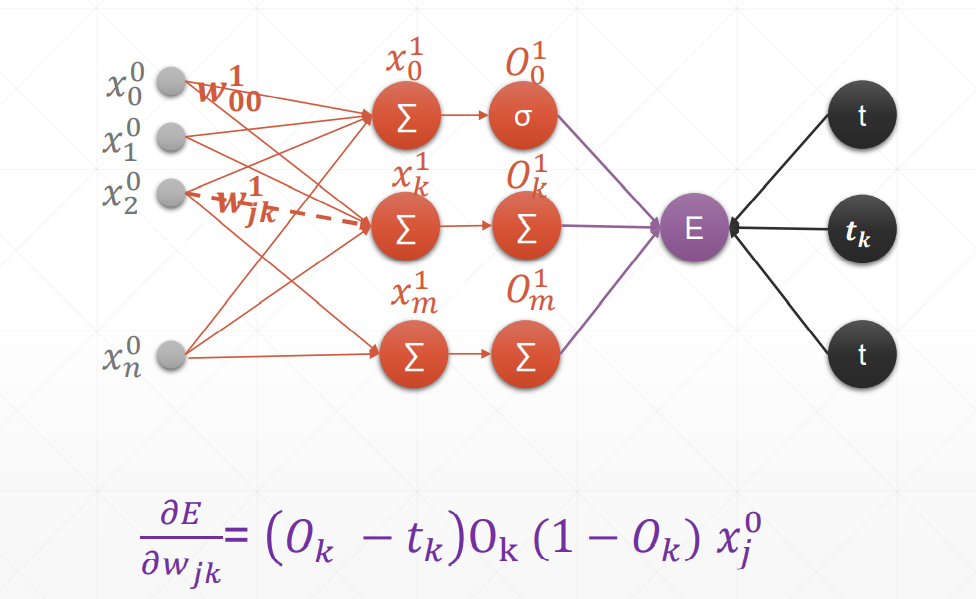

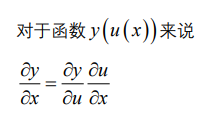

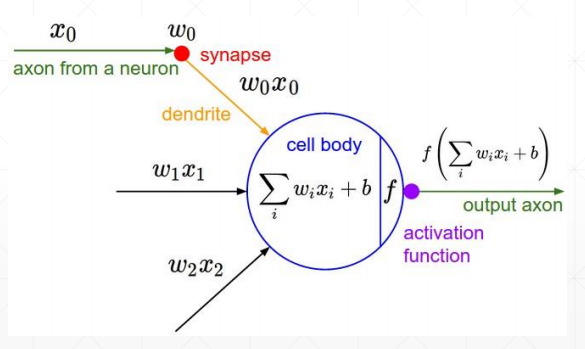

感知机的梯度推导

这里的激活函数是sigmoid激活函数,所以对其求到的结果是,且使用的回归函数是一次线性回归函数。

求导

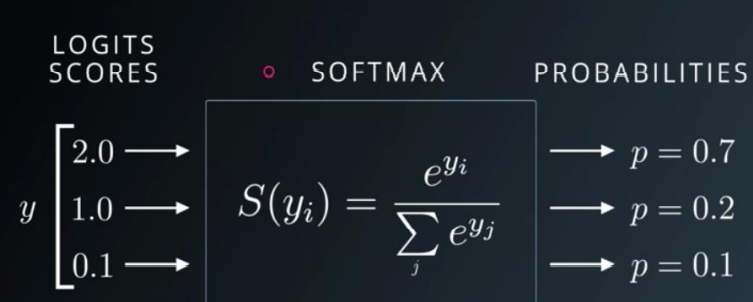

softmax的公式为:

当i=j的时候求导结果为:

当i不等于j的时候求导结果为:

softmax

扩大了值之间的差距

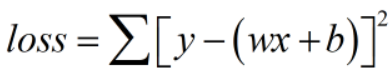

loss及其梯度

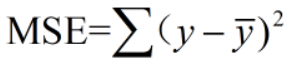

典型的loss函数 有:

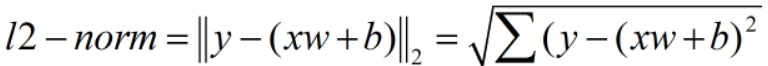

(1)均方差

注意:MSE不同于二范数

MSE不开根号!

求导

(2)Cross Entropy Loss

可以用于二分类、多分类问题,经常使用softmax激活函数

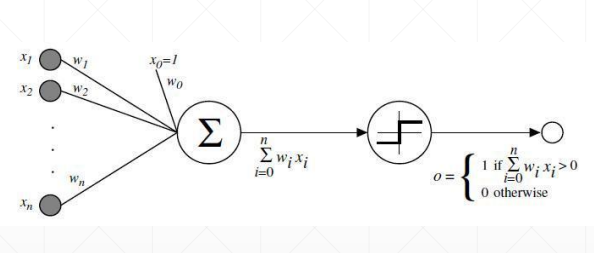

激活函数及其梯度

为了解决激活函数不可导的情况,提出了sigmoid/logistic:光滑可导的函数,且把无穷的值域压缩到[0, 1]的范围内

但是会出现梯度离散的情况,参数无法得到更新,因为越往后,导数值与接近于0

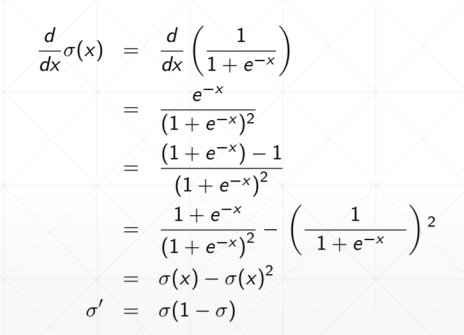

sigmoid函数求导之后如下:

Tanh在RNN里面用得比较多

求导:

Relu使用最多的激活函数

计算导数的时候非常简单,导数为1。不会放大也不会缩小,很大程度上减少了梯度爆炸和梯度离散发生的可能性

递归算法

1.定义递归头

2.递归体

def fact(n):

if n==1:

return n

else:

return n*fact(n-1)

print(fact(5))

import shutil

shutil.make_archive('电影/gg','zip','movie/港台')

import zipfile

z1=zipfile.ZipFile('d:/a.zip','w')

z1.write('1.txt')

z1.write('1_copy.txt')

z.clost()

z2=zipfile.ZipFile('d:/a.zip','r')

z2.extractall('电影')

import shutil

shutil.copyfile('1.txt','1_copy.txt')

shutil.copytree('movie/港台','电影')

import os

path=os.getcwd()

list_files=os.walk(path)

for dirpath,dirnames,filenames in list_files:

for dir in dir names:

print(dir)

import csv

with open('dd.csv','r') as f:

a_csv=csv.reader(f)

print(list(a_csv))

with open('ee.csv','w')as f:

b_csv=csv.writer(f)

b_csv.writerow(['ID','name','age'])

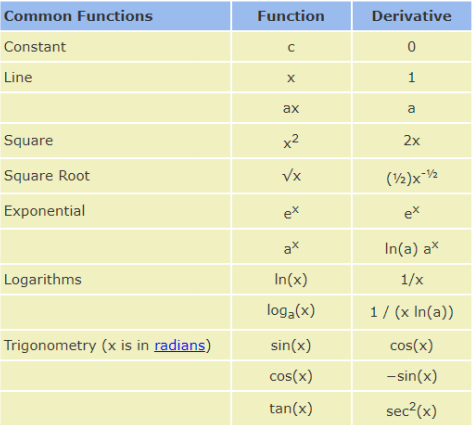

常见函数的梯度

满足上述条件的函数叫做凸函数,不管从哪个方向都能找到全局最优解

容易出现的问题:

(1)有可能会遇到局部最优解

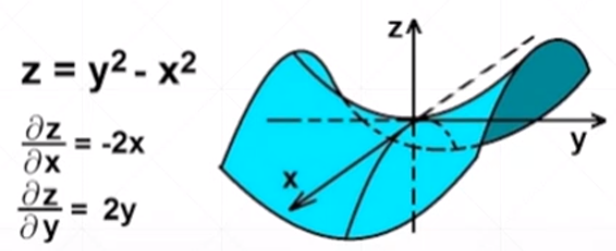

(2)saddle point出现鞍点,在一个自变量上的偏微分取得极大值,在另一个自变量上取极小值

优化梯度下降法来找到全局最优解的因素:

(1)初始状态;

(2)学习率;

(3)momentum——如何逃离局部最小值

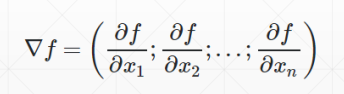

什么叫梯度

导数——反映的是随着x的变化,y的变化趋势

偏微分——指定了自变量的方向上,因变量在某个自变量方向上的变化趋势

梯度——把所有的偏微分看做向量

1、行注释:# 这是一行可以编辑中文的备注

2、断注释:三个英文状态下的引号,两行之间可以编辑中文的备注

"""

。。。

。。。

。。。

。。。

"""

1、保存:ctrl+s 随时保存,养成习惯

2、tab键:默认四个空格

3、注释:# 养成习惯,方便自己,方便他人

4、行连接符(代码太长需要分行时用):\

仅仅是分行用的,代码内容没有断

字符串的格式化

format()

填充与对齐

数字格式化

小数f 整数d