实例属性:从属于实例对象,也成为实例变量。

(1)实例属性一般在__init__()方法中通过如下代码定义:

self.实例属性名=初始值

(2)在本类的其他实例方法中,也是通过self进行访问:

self.实例属性名

(3)创建实例对象后,通过实例对象进行访问:

obj01=类名() #创建对象,调用__init__()初始化属性

obj01.实例属性名=值 #可以给已有属性赋值,也可以新加属性

实例属性:从属于实例对象,也成为实例变量。

(1)实例属性一般在__init__()方法中通过如下代码定义:

self.实例属性名=初始值

(2)在本类的其他实例方法中,也是通过self进行访问:

self.实例属性名

(3)创建实例对象后,通过实例对象进行访问:

obj01=类名() #创建对象,调用__init__()初始化属性

obj01.实例属性名=值 #可以给已有属性赋值,也可以新加属性

构造函数__init__():初始化实例对象的实例属性。

Python对象包含三个部分=id、type、value

只要是类中的方法参数第一个都是self,通过类名()来调用构造函数

对象的进化

面向对象

Python支持面向过程、面向对象、函数式编程等多种编程范式。

LEGB规则

Local:函数或者类的方法内部

nonlocal关键字

nonlocal 用来声明外部的局部变量

global 用来声明全局变量

嵌套函数:在函数内部定义的函数

递归函数:在函数体内直接或者间接的自己调用自己。

(1)终止条件:表示递归什么时候结束,一般用于返回值,不再调用自己。

(2)递归步骤:把第n步的值和第n-1步相关联。

eval()函数

lambda表达式和匿名函数

基本语法:

lambda arg1,arg2,arg3...:<表达式>

可变参数(一个*为元组,**为字典)

强制命名参数(当带星号的“可变参数”后面增加新的参数,必须是强制命名参数)

参数的几种类型

位置参数

默认值参数

命名参数

传递不可变对象:浅拷贝

浅拷贝和深拷贝

浅拷贝:不拷贝子对象的内容,只拷贝子对象的引用。

深拷贝:会连子对象的内存全部拷贝一份,对子对象的修改不会影响源对象。

高效嵌入法embedded

业务选择

说到降维和特征选择,首先要想到的是利用自己的业务能力进行选择,肉眼可见明显和标签有关的特征就是需要留 下的。当然,如果我们并不了解业务,或者有成千上万的特征,那我们也可以使用算法来帮助我们。或者,可以让 算法先帮助我们筛选过一遍特征,然后在少量的特征中,我们再根据业务常识来选择更少量的特征。

PCA和SVD一般不用

逻辑回归是由线性回归演变而来,线性回归的一个核心目的是通过求解参数来探究特征X与标签y之间的 关系,而逻辑回归也传承了这个性质,我们常常希望通过逻辑回归的结果,来判断什么样的特征与分类结果相关, 因此我们希望保留特征的原貌。PCA和SVD的降维结果是不可解释的,因此一旦降维后,我们就无法解释特征和标 签之间的关系了。当然,在不需要探究特征与标签之间关系的线性数据上,降维算法PCA和SVD也是可以使用的。

统计方法可以使用,但不是非常必要

逻辑回归对数据的要求低于线性回归,由于我们不是使用最小二乘法来求解,所以逻辑回归对数据的总体分布和方差没有要求,也不需要排除特征之间的共线性,但如果我 们确实希望使用一些统计方法,比如方差,卡方,互信息等方法来做特征选择,也并没有问题。过滤法中所有的方法,都可以用在逻辑回归上。

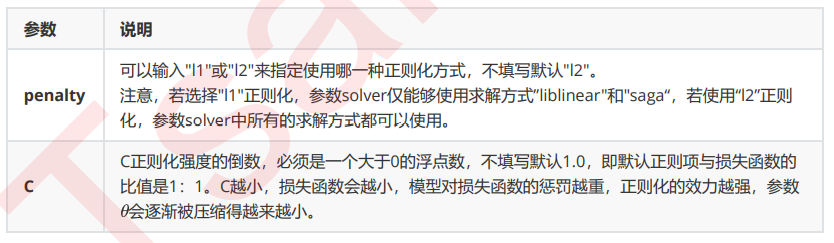

重要参数penatly&C

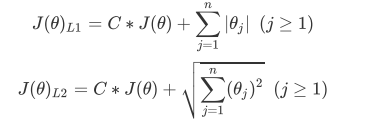

1、正则化

L1正则化和L2正则化虽然都可以控制过拟合,但它们的效果并不相同。当正则化强度逐渐增大(即C逐渐变小), 参数的取值会逐渐变小,但L1正则化会将参数压缩为0,L2正则化只会让参数尽量小,不会取到0。

在L1正则化在逐渐加强的过程中,携带信息量小的、对模型贡献不大的特征的参数,会比携带大量信息的、对模型 有巨大贡献的特征的参数更快地变成0,所以L1正则化本质是一个特征选择的过程,掌管了参数的“稀疏性”。L1正 则化越强,参数向量中就越多的参数为0,参数就越稀疏,选出来的特征就越少,以此来防止过拟合。

相对的,L2正则化在加强的过程中,会尽量让每个特征对模型都有一些小的贡献,但携带信息少,对模型贡献不大 的特征的参数会非常接近于0。通常来说,如果我们的主要目的只是为了防止过拟合,选择L2正则化就足够了。但 是如果选择L2正则化后还是过拟合,模型在未知数据集上的效果表现很差,就可以考虑L1正则化。

为什么需要逻辑回归

1. 逻辑回归对线性关系的拟合效果好到丧心病狂,特征与标签之间的线性关系极强的数据,比如金融领域中的 信用卡欺诈,评分卡制作,电商中的营销预测等等相关的数据,都是逻辑回归的强项。虽然现在有了梯度提 升树GDBT,比逻辑回归效果更好,也被许多数据咨询公司启用,但逻辑回归在金融领域,尤其是银行业中的 统治地位依然不可动摇(相对的,逻辑回归在非线性数据的效果很多时候比瞎猜还不如,所以如果你已经知 道数据之间的联系是非线性的,千万不要迷信逻辑回归);

2. 逻辑回归计算快:对于线性数据,逻辑回归的拟合和计算都非常快,计算效率优于SVM和随机森林,亲测表示在大型数据上尤其能够看得出区别;

3. 逻辑回归返回的分类结果不是固定的0,1,而是以小数形式呈现的类概率数字:我们因此可以把逻辑回归返 回的结果当成连续型数据来利用。比如在评分卡制作时,我们不仅需要判断客户是否会违约,还需要给出确 定的”信用分“,而这个信用分的计算就需要使用类概率计算出的对数几率,而决策树和随机森林这样的分类 器,可以产出分类结果,却无法帮助我们计算分数(当然,在sklearn中,决策树也可以产生概率,使用接口 predict_proba调用就好,但一般来说,正常的决策树没有这个功能)。

另外,逻辑回归还有抗噪能力强的优点。福布斯杂志在讨论逻辑回归的优点时,甚至有着“技术上来说,最佳模型 的AUC面积低于0.8时,逻辑回归非常明显优于树模型”的说法。并且,逻辑回归在小数据集上表现更好,在大型的 数据集上,树模型有着更好的表现。

由此,我们已经了解了逻辑回归的本质,它是一个返回对数几率的,在线性数据上表现优异的分类器,它主要被应 用在金融领域。其数学目的是求解能够让模型对数据拟合程度最高的参数 的值,以此构建预测函数 ,然后将 特征矩阵输入预测函数来计算出逻辑回归的结果y。注意,虽然我们熟悉的逻辑回归通常被用于处理二分类问题, 但逻辑回归也可以做多分类。

重要接口inverse_transform

神奇的接口inverse_transform,可以将我们归一化,标准化,甚至做过哑变 量的特征矩阵还原回原始数据中的特征矩阵,这几乎在向我们暗示,任何有inverse_transform这个接口的过程都 是可逆的。PCA应该也是如此。