索引与切片

索引与切片

4、rand、rand_like、randint

rand随机生成在[0, 1]的数值

rand_like是先把rand生成的数组读取出来再喂给rand函数

randint需要给出最大值、最小值和shape

创建tensor

(1)从numpy进行导入

(2)从list里面导入

小写的tensor括号里接收的是现有数据,而大写Terson、FloatTensor里面接受的是形状,也可以接受现成的数据,括号里用中括号时表示现成的数据,括号时输入的形状

Dim1

一般会用在bias、线性层的输入

Dim2

一般用在batch,当输入多张图片时,第一个数字是图片的个数,第二个是打平图片之后的一维点数

Dim3

适合RNN的文字处理

Dim4

适合CNN

第一个数字是图片的个数,第二个数字是图片的通道,通道为1是灰色图像,通道为3的是菜色图像,后两位数字28*28是minis数据集的长和宽

pytorch中的数据类型

没有对string的支持内键

how to denote string

(1)One-hot并不体现语义

(2)Embedding—word2vec

核实数据类型

数据类型

(1)标量

回归问题实战

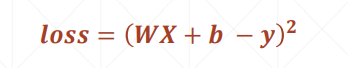

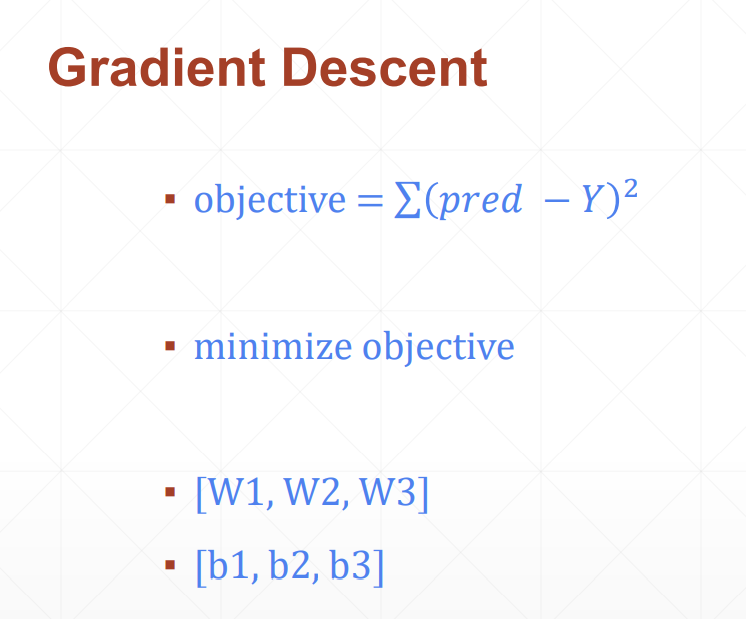

(1)先计算总损失值

(2)然后计算w和b的偏导,进而更新梯度值

需要四步:

(1)load data

(2)build model

(3)train

(4)test

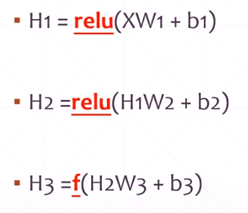

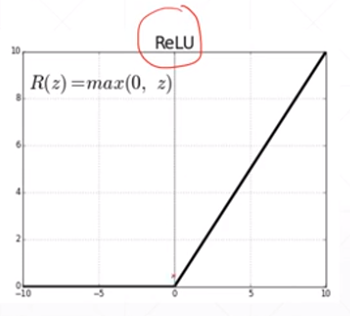

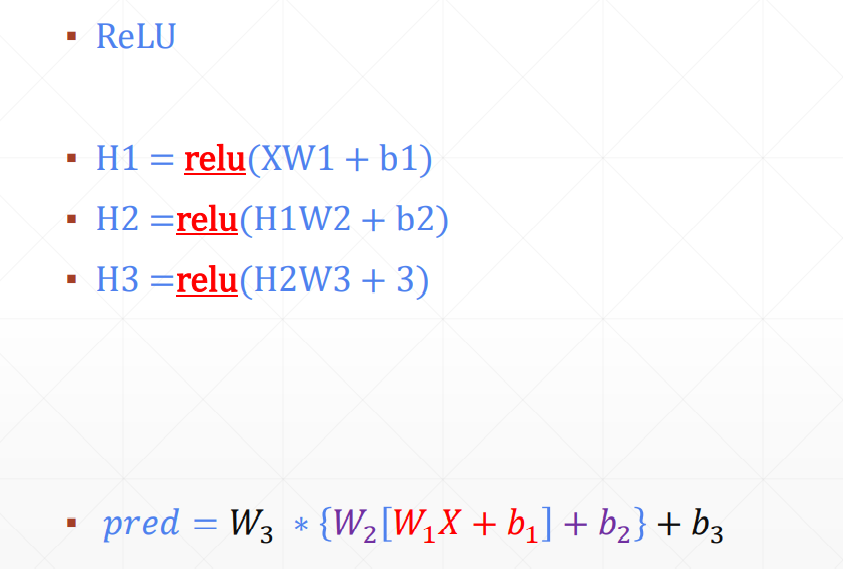

Non-linear Factor

加入激活函数之后

pred既有线性表达能力,还有非线性的表达能力

pytorch的功能:

(1)CPU加速;

没有显卡,用不了cuda

(2)自动求导*非常重要,因为深度学习本质上就是在利用梯度下降法来求最优解;

(3)常用网络层

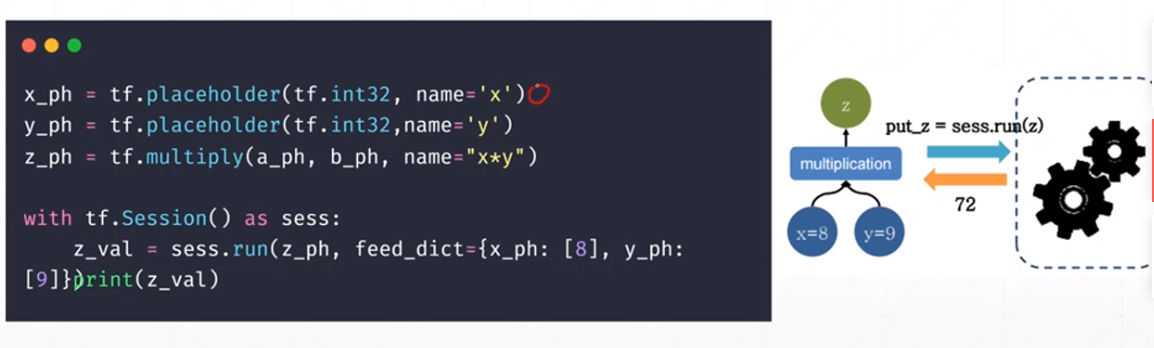

静态图:

define——>run

在最开始就需要定义好公式,给定输入值,得到输出值,而且在运行的过程中无法进行调整

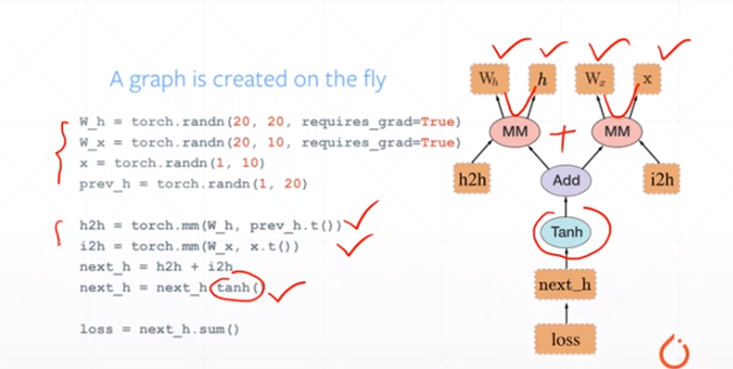

动态图:

可以随时调整公式

linear Regression——我们要估计连续函数的值;

logistic Regression——在上述linear regression的基础上增加了一个激活函数,把y的空间压缩到0-1的范围,0-1可以表示一个概率

classification——所有的可能性概率之和为1

数据降维

1.特征选择

2.主成分分析

MinMaxScaler(feature_range=())

feature_range 可以指定在一定的数值范围内

tf idf

tf:term frenquency词的频率 出现的次数

idf:inverse document frequency 逆文档频率

log(总文档数量/该词出现的文档数量)

重要性程度

countvectorizer没有参数

文本都是放在列表里面的可迭代对象

性能瓶颈,读取速度

格式不太符合机器学习要求数据的格式

可用数据集:

Kaggle

UCI

scikit-learn

机器学习是从数据中自动分析获得规律(模型),并利用规律对未知数据进行预测

1. 解放生产力

2.解决专业问题

3.提供社会便利

梯度下降法

连续[2:5,1:4]跳跃[[2,1],[3,5]]

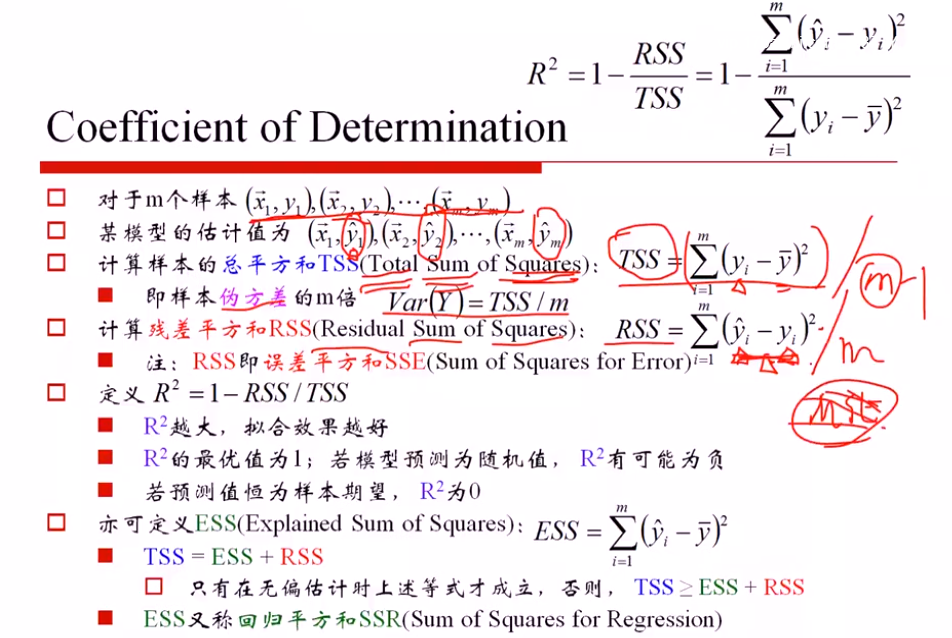

SST (总方差)= SSE() + SSR (残差平方和)

只有无偏估计下成立,否则 SST≥SSE+ SSR

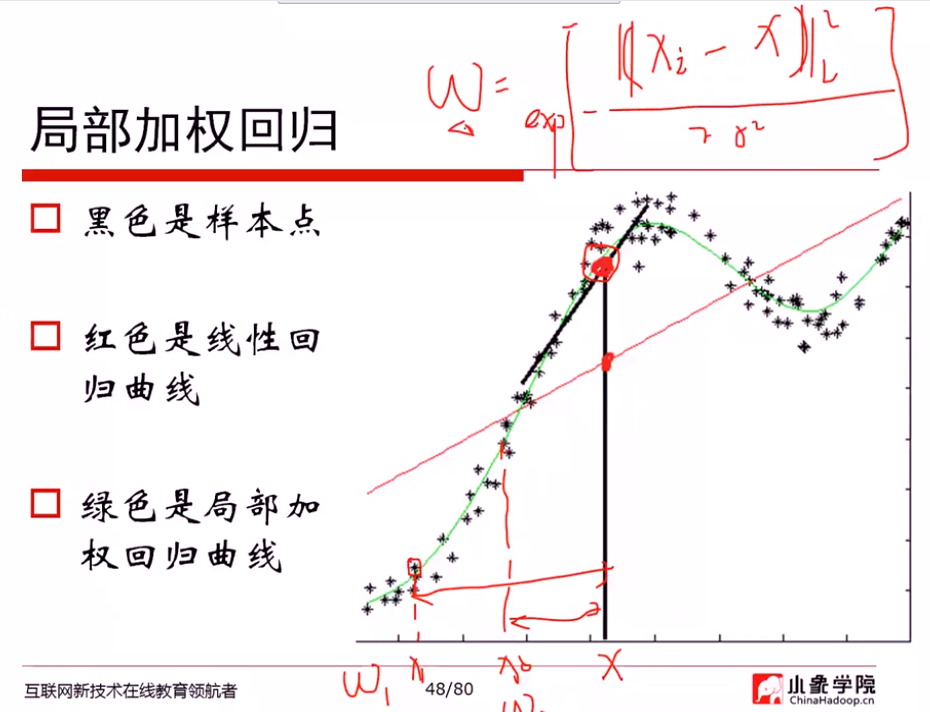

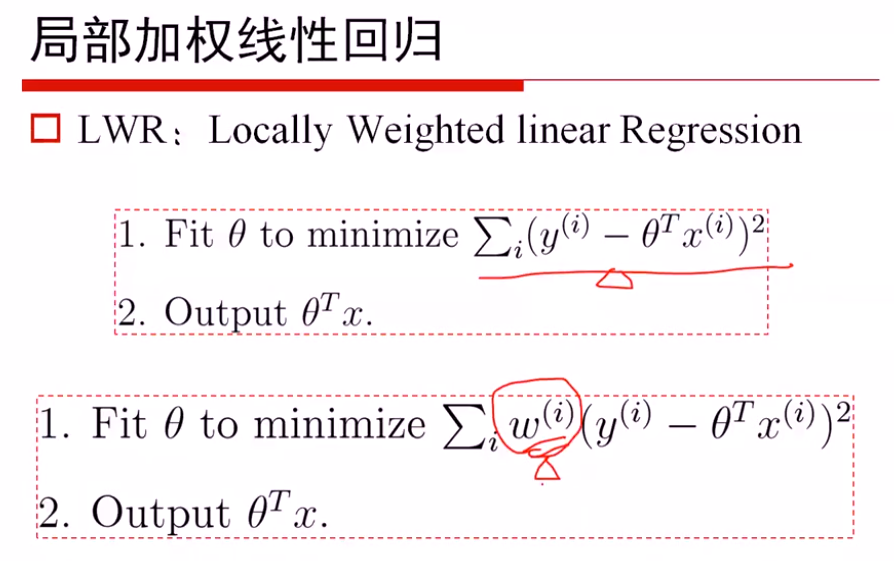

局部加权

最重要的问题: 如何度量权重

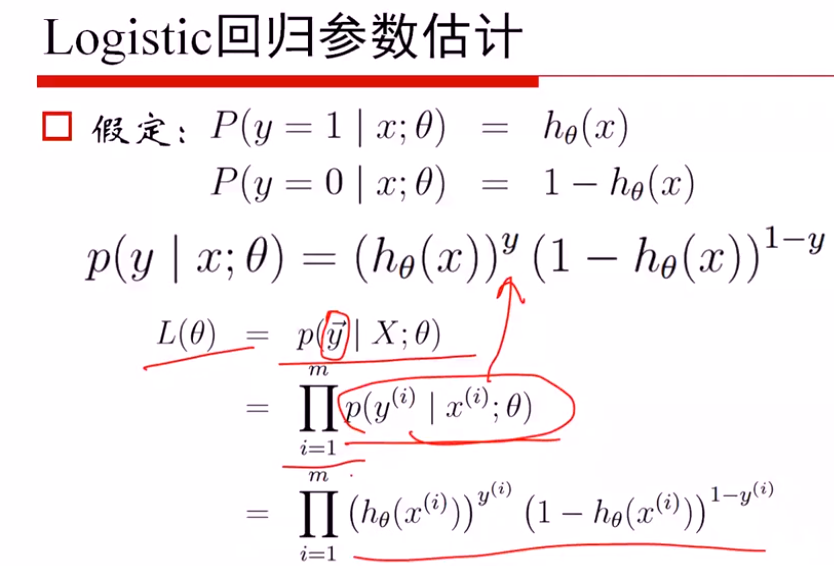

Logistic回归

p(y|x:θ) y=0, y=1时,写成上述密度函数形式

解法1: 从mle求解

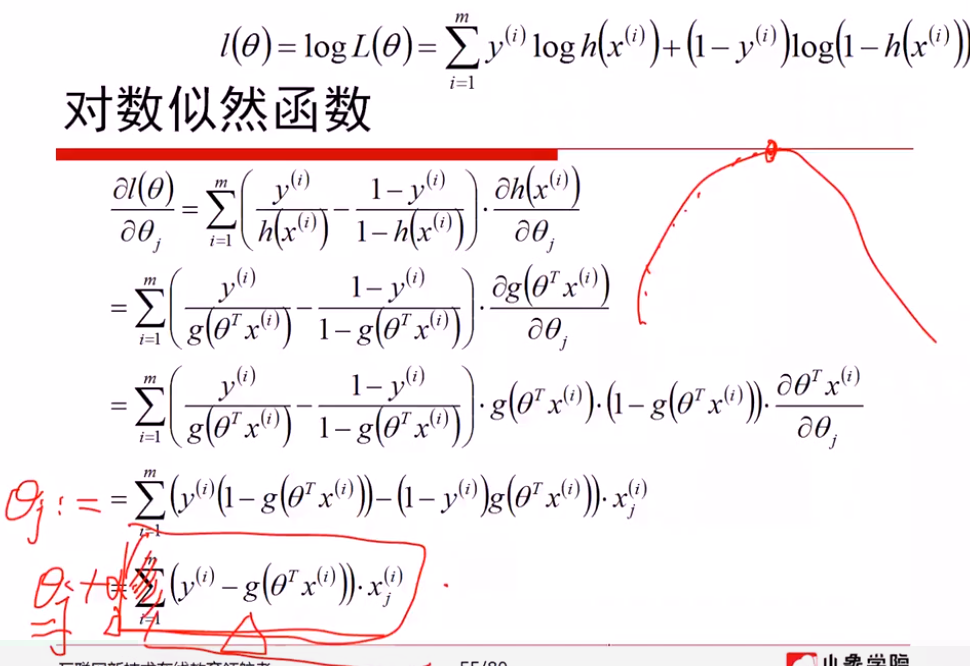

极大似然估计的梯度上升算法,本质与梯度下降无区别,梯度上升取正梯度方向,同样设置步长a;梯度下降选取负梯度方向,

线性回归: 假定服从高斯分布,通过MLE进行估计

logistics回归: 假定服从二项分布,通过MLE进行估计

如果都进行梯度下降法估计,会发现求解的方式都是一样的

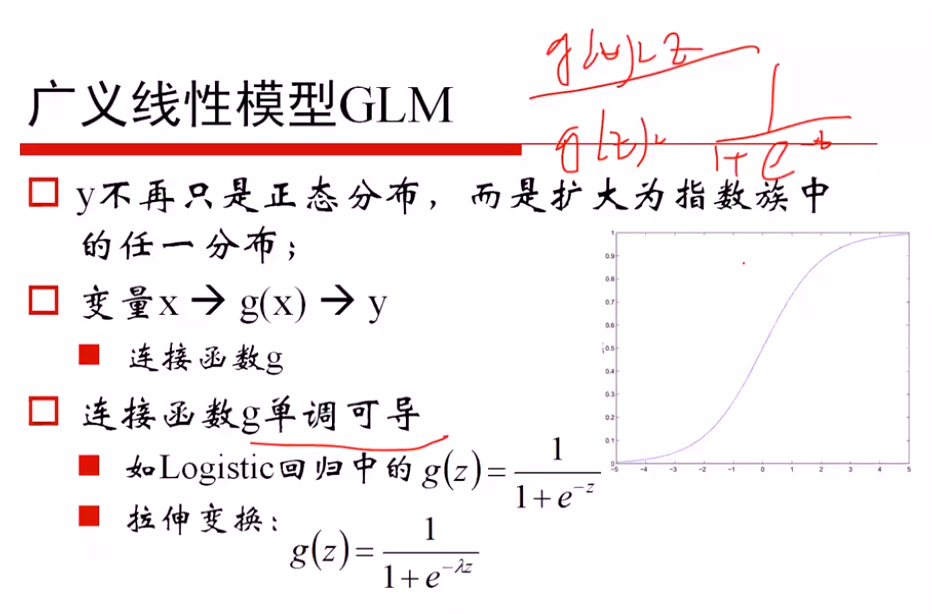

广义线性模型的定义: 因变量不服从正态分布,且因变量与自变量不存在线性关系;广义就是要找一个非线性的关系f,使得转换后更接近因变量的分布

证明是一个广义的线性模型:

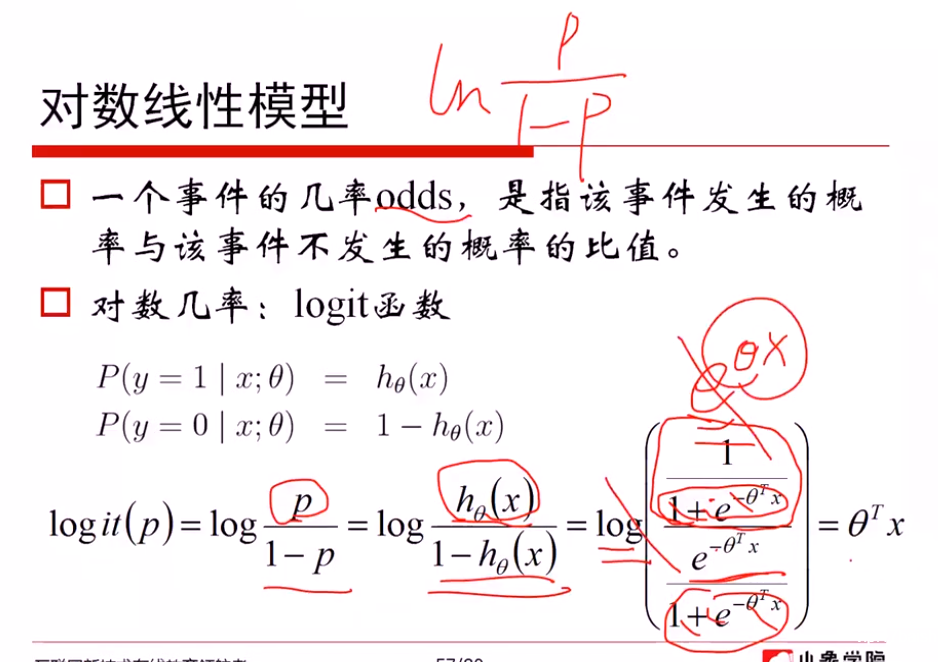

对数线性模型:

从对数模型理解 logistics函数

一方面: 从 ln(p/(1-p)) = θx 推导出 p = logistics函数,说明希望对数模型是线性的,从而推导出概率可以用logistics函数表示

另一方面: 从 p=logistics函数 + ln(p/(1-p))对数模型,推导出对数模型是线性的θTx

广义线性模型 → 相似的梯度下降方法

解法2: 从损失函数进行求解

(1)对 -1, 1转换为0, 1 进行(yi+1)/2...

softmax回归

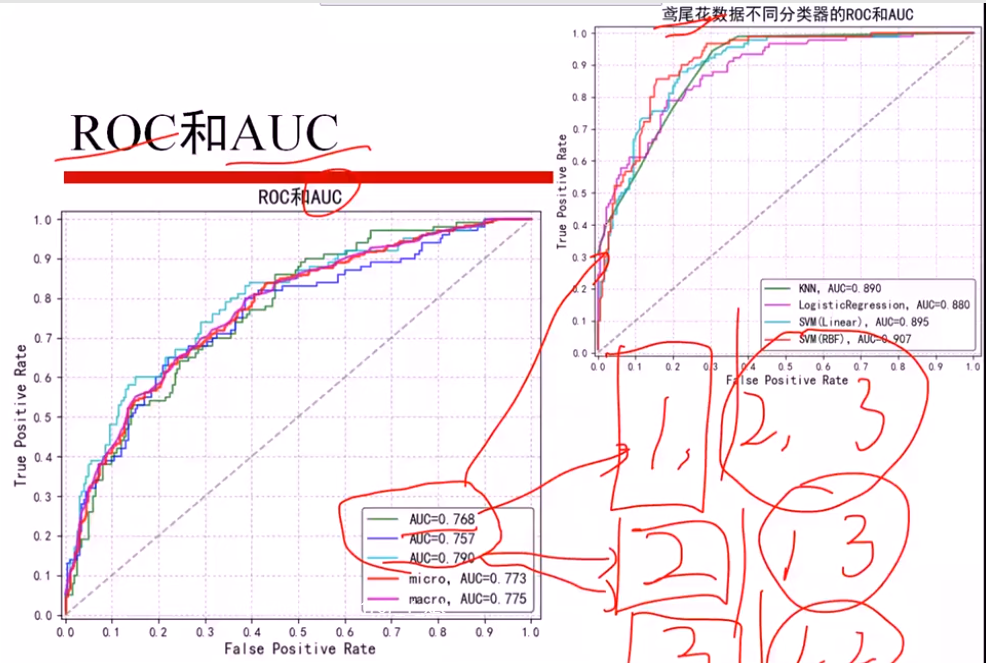

鸢尾花数据

分为三个 二分类问题,算出三个AUCi值

micro: 直接算三个平均AUCi,得出AUC

macro: 总体加和,当作一个AUC计算