SVM实现概率预测

二分类SVC中的样本不均衡问题:重要参数class_weight,接口fit中的参数sample_weight

class_weight:默认为None,可输入字典或balanced(SVM通过在C上加权重影响样本均衡)

sample_weight:数组,必须对应输入fit特征矩阵的每个样本

分类模型天生倾向多数的类

SVM样本总量对运算速度影响大

在数据空间中找出一个超平面作为决策边界,利用决策边界对数据进行分类,决策边界是比数据空间小一维的空间

重要参数C

权衡”训练样本正确分类“和”决策函数边际最大化“(边际更宽的决策边际更好)

浮点数,默认为1,必须大于等于0

调参:一般从0开始调,C越大,决策边界越小

边际更宽的决策边际更好

找最大边际和被分错样本之间的平衡

poly通常用网格搜索调,rbf

与 参数

1) degree:默认3,只在poly时可选

2) gamma:默认auto,除linear都可用

3) coef0:默认0,只在poly,sigmoid有效

np.c_类似np.vstack的功能

ax.text为图像上放上文字

如何使用np.mgrid生成网格?

np.mgrid合并np.linspace和np.meshgrid

xx,yy=np.mgrid[xmin:xmax:200j,ymin:ymax:200j]

[起始值:结束值:步长]

200j表示起始值和结束值之间创建200个点,结束值包含在内

三、非线性SVM与核函数

1、核变换:把数据投影到高维空间中,寻找能将数据完美分割的超平面。

2、核函数使得 高维空间的任意两个向量的点积一定可以用低维空间这两个向量的某种计算表示

3、重要参数kernel:

1)"linear":线性核函数,线性

2) "poly": 多项式核,偏线性

3) "sigmoid": 双曲正切核,非线性

4) "rbf": 高斯径向基,偏非线性

intercept_

线性回归

一、概述

回归的预测结果是连续型变量

二、多元(多个特征)线性回归LinearRegression

1、linear_model.LinearRegression使用的损失函数:SSE(误差平方和)或RSS(残差平方和)

2、最小二乘法:

1)通过最小化真实值与预测值之间的RSS来求解参数

2)最小二乘法求解线性回归是一种无偏估计的方法,要求标签必须服从正态分布

三、回归类的模型评估指标

四、多重共线性:岭回归和Lasso

五、非线性问题:多项式回归

逆矩阵存在的充分必要条件是特征矩阵不存在多重共线性

线性回归

一、概述

回归的预测结果是连续型变量

二、多元(多个特征)线性回归LinearRegression

1、linear_model.LinearRegression使用的损失函数:SSE(误差平方和)或RSS(残差平方和)

三、回归类的模型评估指标

四、多重共线性:岭回归和Lasso

五、非线性问题:多项式回归

线性回归

一、概述

二、多元线性回归LinearRegression

三、回归类的模型评估指标

四、多重共线性:岭回归和Lasso

五、非线性问题:多项式回归

线性回归

一、概述

二、多元线性回归LinearRegression

三、回归类的模型评估指标

四、多重共线性:岭回归和Lasso

五、非线性问题:多项式回归

ROC曲线

衡量在尽量捕捉少数类时,误伤多数类的情况如何变化(recall与

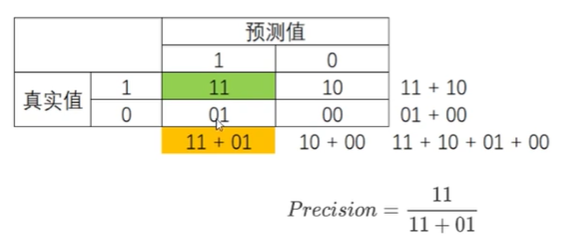

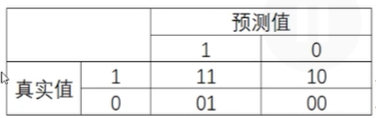

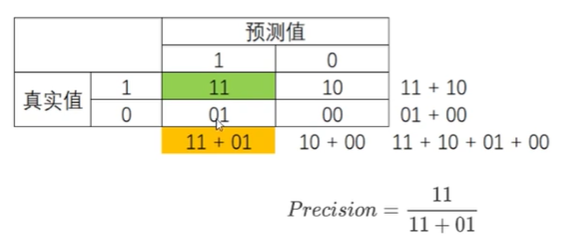

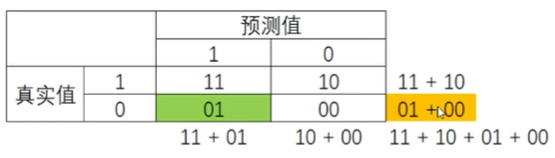

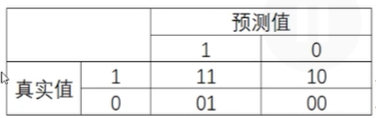

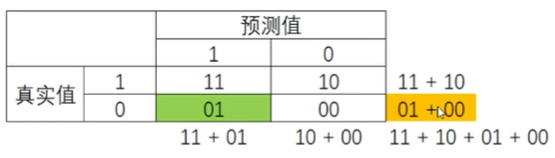

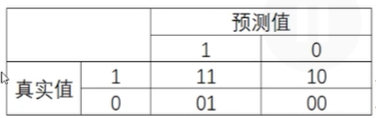

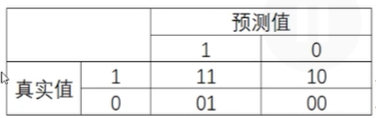

混淆矩阵

二分类中极为有效,少数类为正例,多数类为负例

1)真实值在预测值之前,两数字相同则预测正确

2)所有指标范围在[0,1],11、00为分子的指标越接近1越好,01、10分子的指标越接近0越好

3)sklearn中没有特异度和假正率,需要自己计算

6个指标

1、准确率Accuracy

2、捕捉少数类

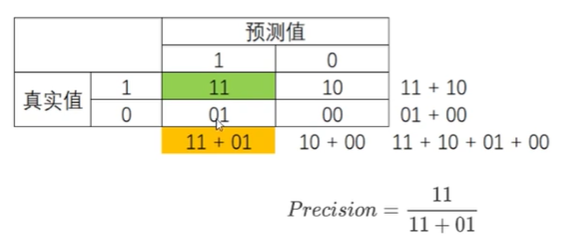

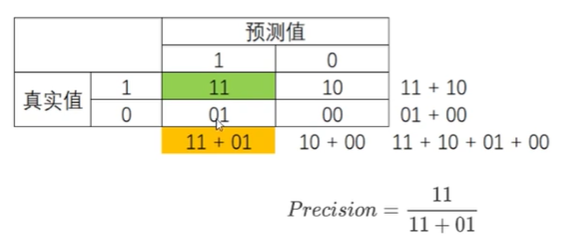

1)精确度Precision(查准率):

越低,误伤了过多的多数类,衡量 多数类判错付出的成本

将多数类判错成本高昂时,追求高精确度

2)召回率Recall(敏感度、真正率、查全率)

越高,捕捉出了越多的少数类

不计一切代价找出少数类,追求高召回率

召回率和精确度此消彼长,代表捕捉少数类的需求和不误伤多数类需求的平衡

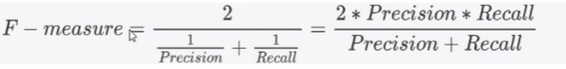

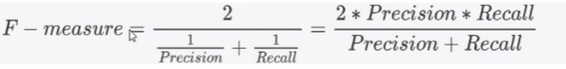

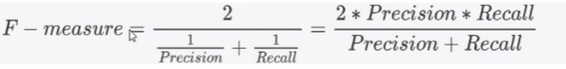

3)F1 measure:范围[0,1],越接近1越好,代表精确度和召回率越高

3、判错多数类

1)特异度specificity(真负率)

衡量一个模型把多数类判断正确的能力

2)假正率false positive rate=1-特异度

衡量一个模型把多数类判断错误的能力

SVC模型评估指标

1、混淆矩阵

二分类中极为有效,少数类为正例,多数类为负例

1)真实值在预测值之前,两数字相同则预测正确

2)所有指标范围在[0,1],11、00为分子的指标越接近1越好,01、10分子的指标越接近0越好

6个指标

1、准确率Accuracy

2、捕捉少数类

1)精确度Precision(查准率):

越低,误伤了过多的多数类,衡量 多数类判错付出的成本

将多数类判错成本高昂时,追求高精确度

2)召回率Recall(敏感度、真正率、查全率)

越高,捕捉出了越多的少数类

不计一切代价找出少数类,追求高召回率

召回率和精确度此消彼长,代表捕捉少数类的需求和不误伤多数类需求的平衡

3)F1 measure:范围[0,1],越接近1越好,代表精确度和召回率越高

3、判错多数类

1)特异度specificity(真负率)

衡量一个模型把多数类判断正确的能力

2)假正率false positive rate=1-特异度

衡量一个模型把多数类判断错误的能力

SVC模型评估指标

1、混淆矩阵

二分类中极为有效,少数类为正例,多数类为负例

1)真实值在预测值之前,两数字相同则预测正确

2)所有指标范围在[0,1],11、00为分子的指标越接近1越好,01、10分子的指标越接近0越好

6个指标

1、准确率Accuracy

2、

1)精确度Precision(查准率):

越低,误伤了过多的多数类,衡量 多数类判错付出的成本

将多数类判错成本高昂时,追求高精确度

2)召回率Recall(敏感度、真正率、查全率)

越高,捕捉出了越多的少数类

不计一切代价找出少数类,追求高召回率

召回率和精确度此消彼长,代表捕捉少数类的需求和不误伤多数类需求的平衡

3)F1 measure:范围[0,1],越接近1越好,代表精确度和召回率越高

SVC模型评估指标

1、混淆矩阵

二分类中极为有效,少数类为正例,多数类为负例

1)真实值在预测值之前,两数字相同则预测正确

2)所有指标范围在[0,1],11、00为分子的指标越接近1越好,01、10分子的指标越接近0越好

6个指标

1、准确率Accuracy

2、精确度Precision(查准率):

越低,误伤了过多的多数类,衡量 多数类判错付出的成本

将多数类判错成本高昂