重点掌握:

hadoop的基本架构:

hadoop1.x:

hdfs:

namenode:主节点,存储元数据信息,处理用户的请求

secondaryNamenode:主要是辅助namenode管理元数据信息的

datanode:从节点,存储数据,出磁盘

mapReduce:

jobTracker:主节点,接收用户的请求,分配任务

taskTracker:从节点,主要用于接受jobTracker分配的任务,并执行任务

hadoop2.x中的架构:

hdfs:分布式文件存储系统

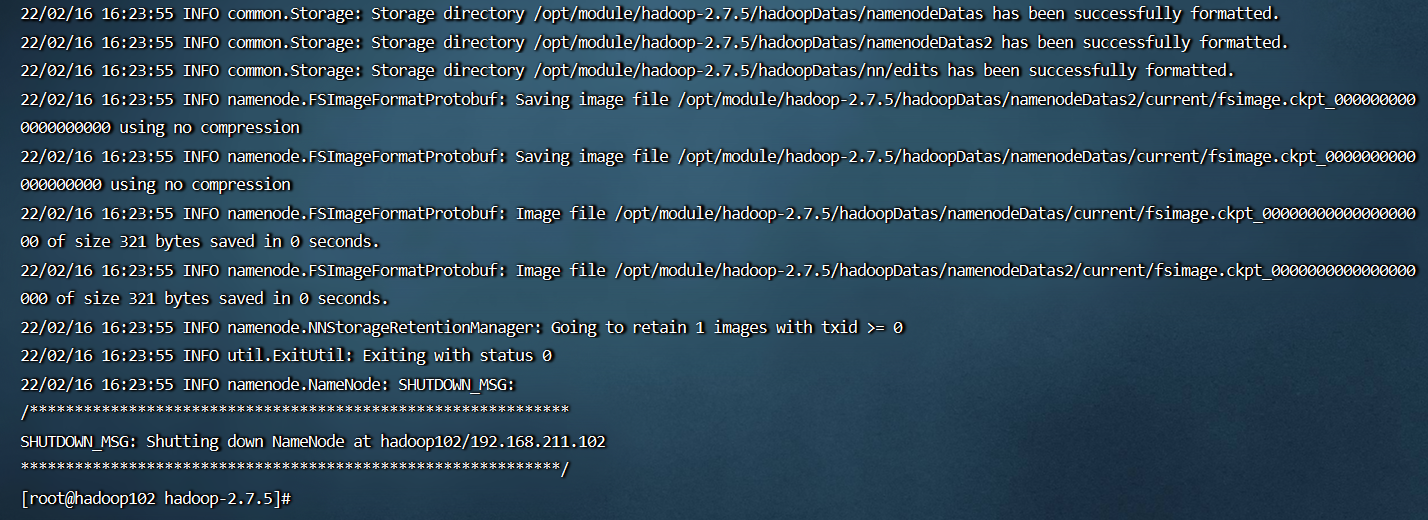

namenode:主节点,主要用于存储元数据信息,处理用户的请求

secondaryNamenode:主要是辅助namenode管理元数据信息

datanode:从节点,主要用于存储数据,出磁盘

如果namenode是高可用,那么就没有secondaryNamenode了,多了journalnode,并且journalnode最好是奇数个

journalNode:同步元数据信息,保证两个那么namenode、里面的元数据一模一样,不然会出现脑裂

zkfc:zkFailoverController 守护进程,与我们的namenode启动在同一台机器,监听namenode的健康状况

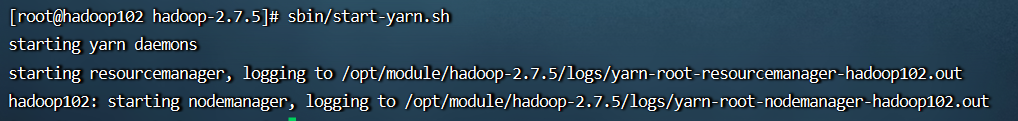

yarn资源调度系统:

resuorceManager:主节点,主要用于接收用户请求,分配资源

nodeMannager:从节点,执行任务

apache的hadoop三种运行环境的搭建

standAlone环境:单机版的hadoop运行环境

伪分布式环境:主节点都在一台机器上面,从节点分开到其他机器上面

完全分布式环境:主节点全部都分散到不同的机器

cdh