梯度爆炸

why?

梯度是有WR的k次方乘以其他的一些东西得到的

当WR大于1的时候,k次方会非常大

当WR小于1的时候,k次方会接近于0

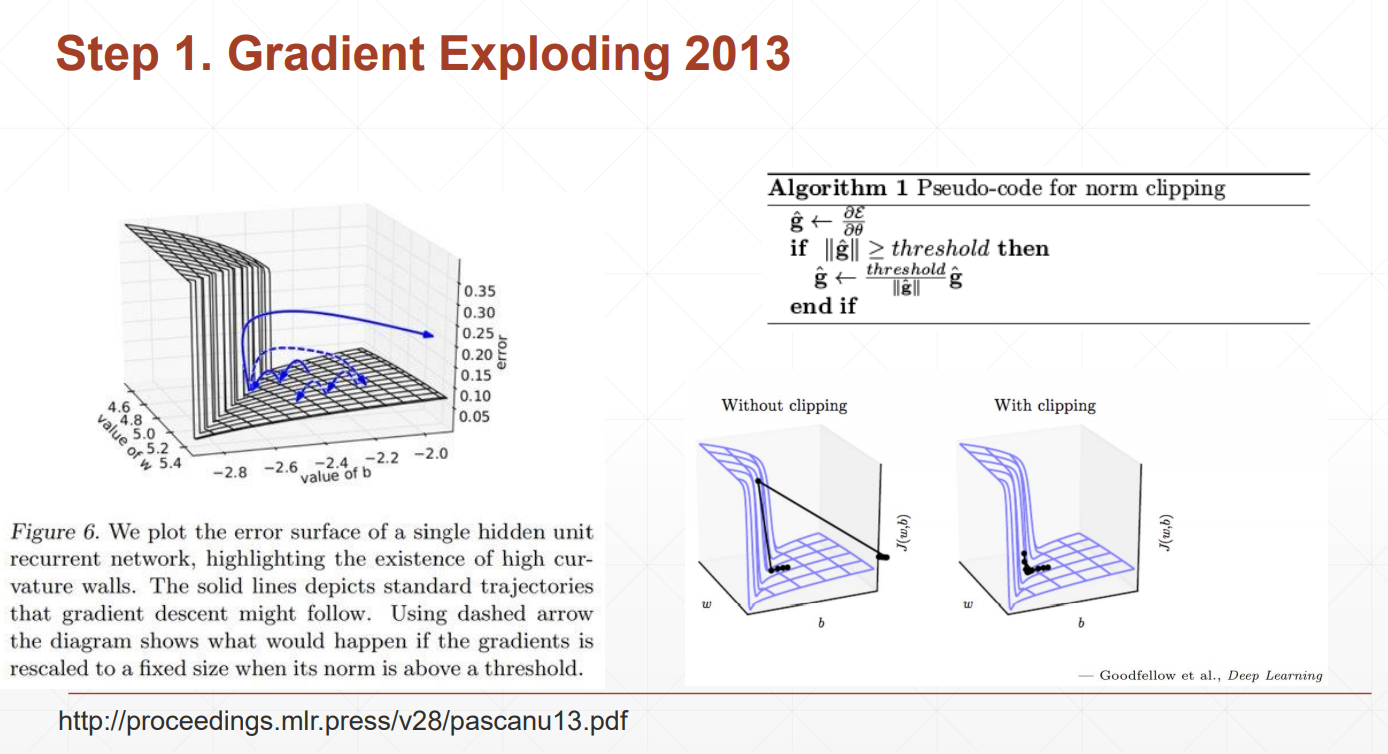

我们的loss本来是逐渐变小的,发生梯度爆炸的loss会突然增大,为了解决这个问题,我们可以检查当前位置的梯度值,如果大于我们设定的阈值,我们将用梯度本身来除以她此刻的模,再乘以阈值,这样使得梯度在设定范围内,且方向不发生变化

Gradient Clipping

查看一下梯度的模,利用clip_grad_norm把梯度的裁剪到10左右

梯度离散:后面隐藏层梯度变化比较大,前面的隐藏层梯度变化很小,长时间得不到更新