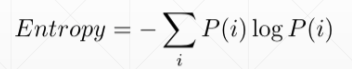

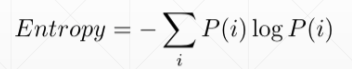

Entropy——熵,指不确定性

熵大则信息量量比较小,越稳定,越没有惊喜度

Cross Entropy

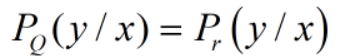

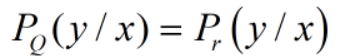

Dkl表示的是两个概率分布的距离,当两个概率分布完全相同的时候,距离为0,Dkl=0

当P=Q时:corss Entropy=Entropy

即H(p,q)=H(p)

且在0ne—hot编码规则下H(p)=0, 那我们优化的目标是:

Entropy——熵,指不确定性

熵大则信息量量比较小,越稳定,越没有惊喜度

Cross Entropy

Dkl表示的是两个概率分布的距离,当两个概率分布完全相同的时候,距离为0,Dkl=0

当P=Q时:corss Entropy=Entropy

即H(p,q)=H(p)

且在0ne—hot编码规则下H(p)=0, 那我们优化的目标是: