criterion 不纯度的衡量指标

有基尼系数和信息熵,信息熵的增益

n_estimators 这是森林中树木的数量,基评估器的数量,default-10

实例化-交叉验证

波动本质上是一样的, 但集成算法压倒性的强

criterion 不纯度的衡量指标

有基尼系数和信息熵,信息熵的增益

n_estimators 这是森林中树木的数量,基评估器的数量,default-10

实例化-交叉验证

波动本质上是一样的, 但集成算法压倒性的强

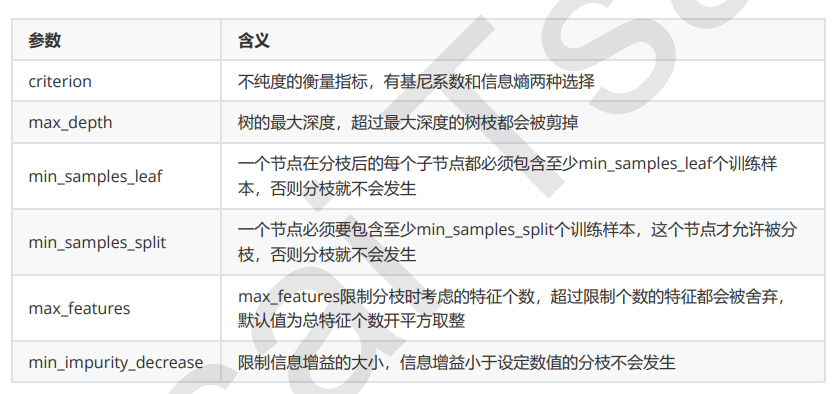

二、RandomForestClassifier(随机森林分类器)参数

1、n_estimators:森林中树木的数量

1)越大往往越好,但计算量越大,达到一定值精确性波动,一般在0-200内选

2)单个决策树准确度越高,随机森林的准确度也会越高

控制基评估器

单个决策树的准确率越高,随机森林的准确率也会越高,因为装袋法是依赖于平均值或 者少数服从多数原则来决定集成的结果的。

n_estimators

n_estimators越 大,模型的效果往往越好。但是相应的,任何模型都有决策边界,n_estimators达到一定的程度之后,随机森林的 精确性往往不在上升或开始波动,并且,n_estimators越大,需要的计算量和内存也越大,训练的时间也会越来越 长。对于这个参数,我们是渴望在训练难度和模型效果之间取得平衡。

n_estimators的默认值在现有版本的sklearn中是10,但是在即将更新的0.22版本中,这个默认值会被修正为 100。这个修正显示出了使用者的调参倾向:要更大的n_estimators。

实操:建一片森林