什么是sklearn?

sklearn是一个开源的基于python语言的机器学习工具包,它通过numpy、scipy和matplotlib等python数值计算的库实现高效的算法应用,涵盖了几乎所有主流机器学习算法。

什么是sklearn?

sklearn是一个开源的基于python语言的机器学习工具包,它通过numpy、scipy和matplotlib等python数值计算的库实现高效的算法应用,涵盖了几乎所有主流机器学习算法。

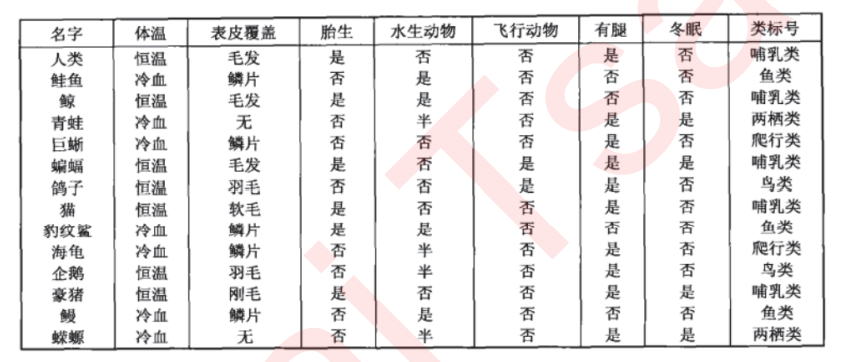

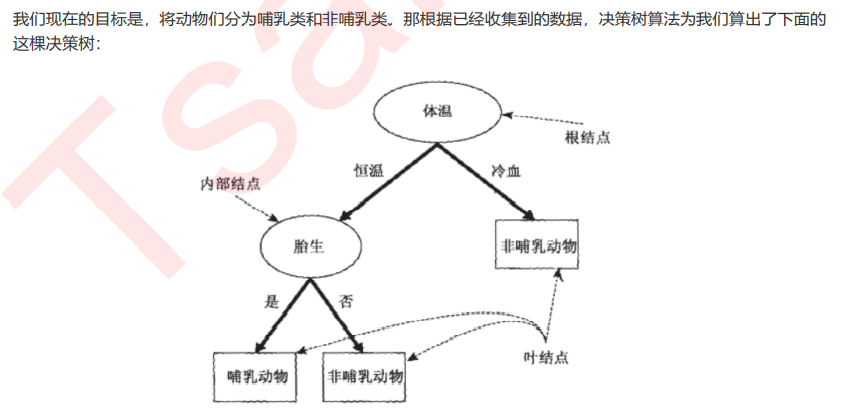

决策树

1、概述

决策树是一种非参数的有监督学习方法,它能够从一系列有特征和标签的数据中总结出决策规则,以解决分类和回归问题。

2、关键概念:节点

根节点:没有进边,有出边。包含最初的,针对特征的提问。

中间节点:既有进边也有出边,进边只有一条,出边可以有很多条。都是针对特征的提问。

叶子节点:有进边,没有出边,每个叶子节点都是一个类别标签。

子节点和父节点:在两个相连的节点中,更接近根节点的是父节点,另一个是子节点。/3、

3、决策树算法的核心是要解决两个问题:

1)如何从数据表中找出最佳节点和最佳分枝? 2)如何让决策树停止生长,防止过拟合?

4、模块sklearn.tree的使用

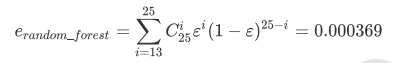

随机森林的本质是一种装袋集成算法(bagging),装袋集成算法是对基评估器的预测结果进行平均或用多数表决 原则来决定集成评估器的结果。在刚才的红酒例子中,我们建立了25棵树,对任何一个样本而言,平均或多数表决 原则下,当且仅当有13棵以上的树判断错误的时候,随机森林才会判断错误。单独一棵决策树对红酒数据集的分类 准确率在0.85上下浮动,假设一棵树判断错误的可能性为0.2(ε)。所以,当一共有25棵树时,判断错误的可能性为:

可见,判断错误的几率非常小,这让随机森林在红酒数据集上的表现远远好于单棵决策树。

随机森林中其实也有random_state,用法和分类树中相似,只不过在分类树中,一个random_state只控制生成一 棵树,而随机森林中的random_state控制的是生成森林的模式,而非让一个森林中只有一棵树。

当random_state固定时,随机森林中生成是一组固定的树,但每棵树依然是不一致的,这是 用”随机挑选特征进行分枝“的方法得到的随机性。并且我们可以证明,当这种随机性越大的时候,袋装法的效果一 般会越来越好。用袋装法集成时,基分类器应当是相互独立的,是不相同的。

bootstrap & oob_score

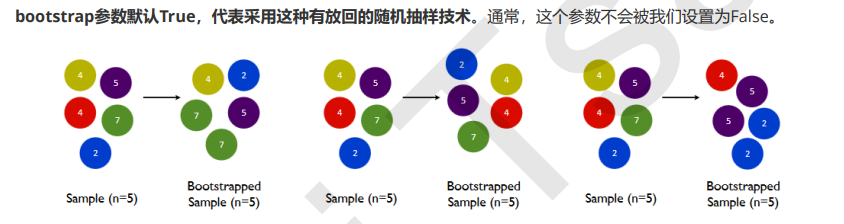

要让基分类器尽量都不一样,一种很容易理解的方法是使用不同的训练集来进行训练,而袋装法正是通过有放回的随机抽样技术来形成不同的训练数据,bootstrap就是用来控制抽样技术的参数。

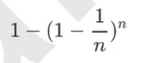

一般来说,自助集大约平均会包含63%的原始数据。因为每一个样本被抽到某个自助集中的概率为:

当n足够大时,这个概率收敛于1-(1/e),约等于0.632。因此,会有约37%的训练数据被浪费掉,没有参与建模, 这些数据被称为袋外数据(out of bag data,简写为oob)。

也就是说,在使用随机森林时,我们可以不划分测试集和训练集,只需要用袋外 数据来测试我们的模型即可。

重要属性和接口

网格搜索:能够帮助我们同时调整多个参数的技术——枚举技术

剪枝参数

在不加限制的情况下,一棵决策树会生长到衡量不纯度的指标最优,或者没有更多的特征可用为止。这样的决策树 往往会过拟合,这就是说,它会在训练集上表现很好,在测试集上却表现糟糕。

为了让决策树有更好的泛化性,我们要对决策树进行剪枝。剪枝策略对决策树的影响巨大,正确的剪枝策略是优化 决策树算法的核心。

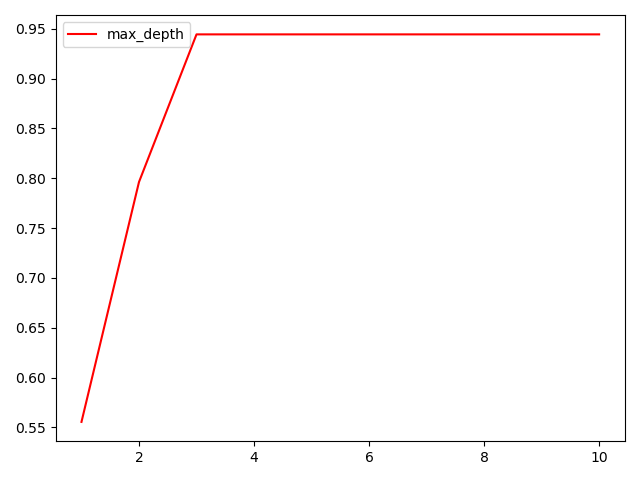

·max_depth

限制树的最大深度,超过设定深度的树枝全部剪掉 这是用得最广泛的剪枝参数,在高维度低样本量时非常有效。决策树多生长一层,对样本量的需求会增加一倍,所 以限制树深度能够有效地限制过拟合。实际使用时,建议从=3开始尝试,看看拟合的效 果再决定是否增加设定深度。

·min_samples_leaf & min_samples_split min_samples_leaf

限定,一个节点在分枝后的每个子节点都必须包含至少min_samples_leaf个训练样本,否则分 枝就不会发生,或者,分枝会朝着满足每个子节点都包含min_samples_leaf个样本的方向去发生。

一般搭配max_depth使用,在回归树中有神奇的效果,可以让模型变得更加平滑。这个参数的数量设置得太小会引 起过拟合,设置得太大就会阻止模型学习数据。一般来说,建议从=5开始使用。

min_samples_split限定,一个节点必须要包含至少min_samples_split个训练样本,这个节点才允许被分枝,否则 分枝就不会发生。

随机森林

集成算法概述

集成学习(ensemble learning)是时下非常流行的机器学习算法,它本身不是一个单独的机器学习算法,而是通 过在数据上构建多个模型,集成所有模型的建模结果。基本上所有的机器学习领域都可以看到集成学习的身影,在 现实中集成学习也有相当大的作用,它可以用来做市场营销模拟的建模,统计客户来源,保留和流失,也可用来预 测疾病的风险和病患者的易感性。在现在的各种算法竞赛中,随机森林,梯度提升树(GBDT),Xgboost等集成 算法的身影也随处可见,可见其效果之好,应用之广。

多个模型集成成为的模型叫做集成评估器(ensemble estimator),组成集成评估器的每个模型都叫做基评估器 (base estimator)。通常来说,有三类集成算法:装袋法(Bagging),提升法(Boosting)和stacking。

装袋法的核心思想是构建多个相互独立的评估器,然后对其预测进行平均或多数表决原则来决定集成评估器的结 果。装袋法的代表模型就是随机森林。

提升法中,基评估器是相关的,是按顺序一一构建的。其核心思想是结合弱评估器的力量一次次对难以评估的样本 进行预测,从而构成一个强评估器。提升法的代表模型有Adaboost和梯度提升树。

max_features & min_impurity_decrease

一般max_depth使用,用作树的”精修“

·max_features

限制分枝时考虑的特征个数,超过限制个数的特征都会被舍弃。和max_depth异曲同工,max_features是用来限制高维度数据的过拟合的剪枝参数,但其方法比较暴力,是直接限制可以使用的特征数量 而强行使决策树停下的参数,在不知道决策树中的各个特征的重要性的情况下,强行设定这个参数可能会导致模型 学习不足。如果希望通过降维的方式防止过拟合,建议使用PCA,ICA或者特征选择模块中的降维算法。

·min_impurity_decrease限制信息增益的大小,(信息增益是用父节点的信息熵-子节点的信息熵)信息增益小于设定数值的分枝不会发生。这是在0.19版本中更新的功能,在0.19版本之前时使用min_impurity_split。

剪枝参数可以通过学习曲线来找到最优参数

无论如何,剪枝参数的默认值会让树无尽地生长,这些树在某些数据集上可能非常巨大,对内存的消耗也非常巨 大。所以如果你手中的数据集非常巨大,你已经预测到无论如何你都是要剪枝的,那提前设定这些参数来控制树的 复杂性和大小会比较好。

回归树:参数、属性和接口

criterion

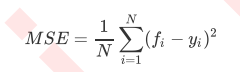

回归树衡量分枝质量的指标,支持的标准有三种: 1)输入"mse"使用均方误差mean squared error(MSE),父节点和叶子节点之间的均方误差的差额将被用来作为 特征选择的标准,这种方法通过使用叶子节点的均值来最小化L2损失

2)输入“friedman_mse”使用费尔德曼均方误差,这种指标使用弗里德曼针对潜在分枝中的问题改进后的均方误差

3)输入"mae"使用绝对平均误差MAE(mean absolute error),这种指标使用叶节点的中值来最小化L1损失 属性中最重要的依然是feature_importances_,接口依然是apply, fit, predict, score最核心。

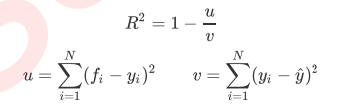

在回归树中,MSE不只是我们的分枝质量衡量指标,也是我们最常用的衡 量回归树回归质量的指标,当我们在使用交叉验证,或者其他方式获取回归树的结果时,我们往往选择均方误差作 为我们的评估(在分类树中这个指标是score代表的预测准确率)。在回归中,我们追求的是,MSE越小越好。然而,回归树的接口score返回的是R平方,并不是MSE。

y尖儿是标签的平均值。虽然均方误差永远为正,但是sklearn当中使用均方误差作为评判标准时,却是计算”负均方误 差“(neg_mean_squared_error)。这是因为sklearn在计算模型评估指标的时候,会考虑指标本身的性质,均 方误差本身是一种误差,所以被sklearn划分为模型的一种损失(loss),因此在sklearn当中,都以负数表示。真正的 均方误差MSE的数值,其实就是neg_mean_squared_error去掉负号的数字。

# 分类算法-朴素贝叶斯算法

## 一、概率基础

> 概率被定义为一件事件发生的可能性

## 二、联合概率和条件概率

> 联合概率:包含多个条件,且所有条件同时成立的概率 p(a,b)=p(a)xp(b)

> 条件概率:就是事件a在另外一个事件b已经发生条件下的发生概率 记作p(a|b), p(a1,a2|b)=p(a1|b)p(a2|b), 次条件概率的成立,是由于a1,a2相互独立的结果

### 例题

## 三、朴素贝叶斯 : 特征之间需要相互独立

### 文档分类

- p(科技|文档) 文档1: 词1,词2,词3

- p(娱乐|文档) 文档2:词a,词b,词c

### 贝叶斯公式

# 分类算法:逻辑回归

> 逻辑回归:线性回归的式子作为输入,解决二分类问题, 也可以得出概率值

## 1、应用场景(基础分类问题:二分类)

- 广告点击率

- 是否为垃圾邮件

- 是否患病

- 金融诈骗

- 虚假账号

## 2、广告点击

- 点击

- 没点击

## 3、逻辑回归的输入与线性回归相同

# 模型的保存和加载

from sklearn.externals import joblib

Max pooling 采样取各样区内最大

avg pooling 取平均

# 分类算法:决策树、随机森林

## 1、认识决策树

### 决策树的划分

## 2、信息的度量和作用

> 信息的单位:比特

### 信息熵

> 信息和消除不确定性xiang'guan

# 模型选择与调优

## 1、交叉验证

> 为了让被评估的模型更加准确可信\

> 将训练集再分为训练集和验证集 将所有数据分成n等分

##2、网格搜索:调参数

K-近邻:超参数

> 通常情况下,很多参数需要手动指定,如k值,这种叫超参数。每组超参数都采用交叉验证来进行评估。最后选出最优参数组合建立模型

# 分类模型的评估

> estimator.score()

- 一般最常见使用的是准确率,即预测结果正确的百分比

## 精确率和召回率

> 预测结果为正例样本中真实为正例的比例(查得准)

> 召回率:真实为正例的样本中预测结果为整理的比例(查的全,对正样本的区分能力)

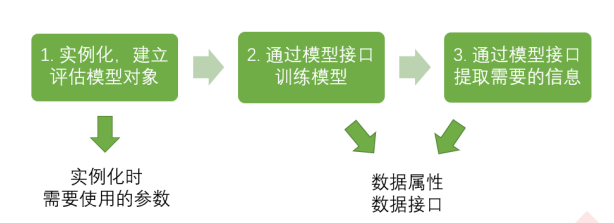

## 转换器与估计器

> 引入:实例化是一个转换器类,调用fit_transfrom

# 数据的划分和介绍

## 1、sklearn 数据集

### 数据集划分

- 训练集 占大多数 70% 80% 75% 构建模型

- 测试集 30% 20% 25% 用于评估模型是否有效

sklearn.model_selection.train_test_split

## 数据降维

> 维度:特征的数量

> 为什么要降维:删除一些不必要的特征

- 特征选择

- 主成分分析

### 特征选择

特征选择的原因

- 冗余:部分特征相关度高,容易消耗计算性能

- 噪声:部分特征对预测结果有影响

特征选择的主要方法

- filter 过滤式 variance threshold

- embedded 嵌入式 正则化、决策树

- wrapper 包裹式

### 过滤式特征选择

sklearn.feature_selection.VarianceThreshold

> 特征之间容易相关 对于高纬度数据来说

n_components:

- 小数 百分比(0~1)保留多少信息 一般取90~95%

- 整数 减少到的特征数量

一般使用小数

sklearn.preprocessing.MinMaxScaler

### tf_ idf分析

朴素贝叶斯

> tf: term frequency(词的频率) 出现的次数

> idf: 逆文档频率 inverse document frequency 公式:log(总文档数量/该词出现的文档数量)

log() 输入的数值越小,结果越小。

> tf*idf 重要性 用以苹果一个词对于一个文件集或一个语料库中的其中一份文件的重要程度。

sklearn.feature_extraction.text.TfidVectorizer